spark读取目录及子目录中文件

2022-04-26 16:16:08 作者 : 短巷与雨 围观 : 99次 评论

spark读取目录及子目录中文件?接下来教大家spark如何读取目录及子目录中文件。

在spark输入1 val rdd=spark.sparkContext.textFile("D:\\data\\test_table\\*=1,D:\\data\\test_table\\key=2")

注意:

每个路径都要定位到最后一级。

路径之间不能存在包含关系。

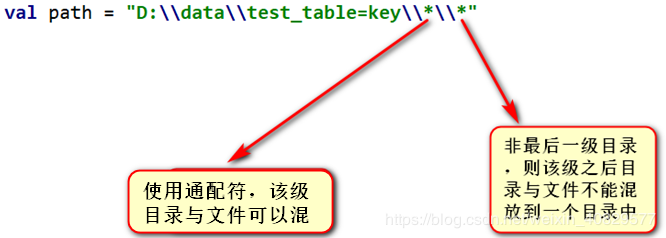

目录与文件不要混放,即放在同一个目录下。

路径中可使用通配符。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。